新网站的SEO优化能够确保您的独立站在搜索引擎结果中获得良好排名的关键。通过合理的SEO优化策略,可以增加你的网站曝光度、吸引更多的有针对性的访问者,并最终实现更高的转化率。本文将为您介绍一些关键的新网站SEO优化方法,帮助你提升网站在搜索引擎中的排名。

一、新网站上线前的基础内容优化

1.筛选目标关键词

使用谷歌官方或第三方关键词工具筛选目标关键词,对关键词进行分类规划,挑选主次,自然有序的布置到网站标题及描述中。

2.创建标签

为每个网页创建独特的标题标签,每一个网页需要有一个独一无二的标题标签,这可以帮助Google将它和其他网页区别开来。

3.优化页面及URL

优化页面导航及URL的层级,这里要注意以下几点:

①在URL中使用单词,包含与网站内容和结构相关的单词;

②使用相对简单的网站层级结构;

③避免重复性URL,一条URL仅对应一个页面;

④在URL中使用小写。

4.建立sitemap文件

无论是新站还是老站,sitemap是不可或缺的,可以让Google更容易发现并抓取URL及网站上的内容。

5.完善站点基础设置

完善站点基础设置,需要检查以下几个方面:

①设置站点SSL证书和HTTPS;

②检查站点加载速度优化并处理;

③检查全站URL是否有死链或无效重复URL并处理;

④完善元标签、robots、移动端适配;

⑤完善网站订阅、邮箱等入口及结构化数据提交;

⑥确保服务器稳定。

6.持续创造内容

可持续性创建内容及外链,持续为用户和搜索引擎生产所需要的,有价值的内容。

二、新网站上线没有被收录的原因有哪些?

上线1~3个月的新网站不被收录这个现象还是很常见,一般新站上线首页收录时间大概20天,而内录页面收录时间大概需要30天。如果网站上线时间已超过20天,首页都还没被收录,那就有问题了。

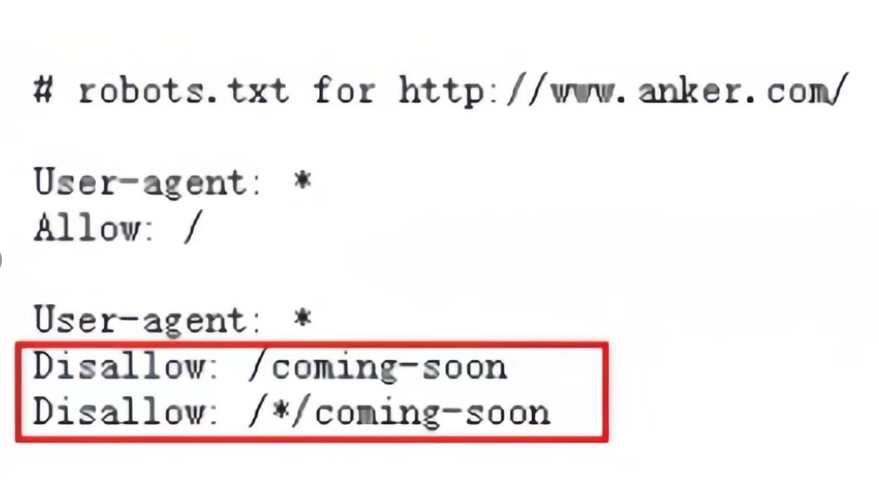

1. robots.txt设置了不可被抓取

robots文件告诉了搜索引擎要抓取哪些网页和不要抓取哪些网页。

检查你的robots文件中disallow部分代码,看看不被收录的网页是不是触发了disallow规则。

比如我们来看anker的robots.txt, 它禁止了谷歌去爬URL中带有/coming-soon的网页。也就是说,如果你的网页URL是https://www.anker.com/coming-soon/power-adapter,那通常(非绝对)谷歌就不会去爬它。

最快的解决方法是在robots文件中加一行Allow代码:

Allow: https://www.anker.com/coming-soon/power-adapter(要谷歌被爬行的网址)

2. 网页HTML代码加了noindex标签

noindex标签的作用是告诉搜索引擎不要去索引该页面。

检查方法:页面右击->查看网页源代码->搜“noindex”, 如果你发现有以下这行代码:

<meta name="robots" content="noindex,nofollow" />

那你要做的就是去掉这行代码。

3. canonical标签指向另外一个网页

canonical标签是为了解决网址规范化问题,告诉搜索引擎那个网址才是最重要的。

网页可以不带canonical标签。我发现很多网站的页面都会带上canonical标签, 链接指向本页面;如果链接指向非本页面, 那谷歌很多时候(非绝对)就不会抓取该页面。

检查方法:页面右击->查看网页源代码->搜“canonical”,如果canonical标签里的链接不是本页面的URL,那你要做的就是把链接改成本页面的URL,或者直接去掉canonical这行代码。

4. HTTP 状态码为404、500、301、302

托管站点的服务器在响应搜索蜘蛛爬虫发出的请求时会生成HTTP状态码。

我们经常遇到的会造成搜索爬虫无法抓取页面的HTTP状态码是404、500、301和302。

如果打开网页,发现返回了以上状态码提示,无法访问,那你要做的是去找网站开发人员去处理。

正常能让搜索引擎爬虫和用户访问的页面的状态码是200。

5. 没有入口(通常是指没有内部或外部链接)

蜘蛛在工作时通常从一个 URL 开始,然后从顺着爬到其它URL。如果你的页面是孤立的,那就很难被蜘蛛爬到。因此,我们需要给搜索引擎蜘蛛一个引导。

以下是三种简单又快速增加入口的方式:

把链接加入到XML sitemap。

找到自己网站内和此页面内容有相关联的网页,增加一个指向该页面的内链。

在第三方网站分享链接,比如Twitter,Facebook和一些RSS网站。

6. 抓取预算不足

谷歌有数千台机器来运行蜘蛛,但有一百万个网站等待被抓取。因此,每个蜘蛛到达你的网站时都会有预算,也就是它们可以在你网站花费的资源数量是有限的。

以下三种方法都可以提高抓取预算:

用robots.txt屏蔽掉不做SEO、也不会影响整站SEO排名的页面。

确保网页能够快速加载。

提高网站的权威度。

以上就是常见的在搜索引擎第一阶段工作时就遇到了阻碍导致到无法正常进入索引的情景。

接下来讲讲因为谷歌觉得页面质量不行从而不值得去收录的三种常见情况。

7. 内容质量低

举个极端的例子:一个页面只有一行话,这种内容极度薄弱的页面, 是几乎不可能通过谷歌的收录。

没什么捷径可走,就是提高页面内容的质量。

8. 内容重复度高

举个常见的例子 :你的网站转载了一篇由行业内名人撰写的非常专业的文章,而且这篇文章也被很多其它网站转载了,谷歌就会认为这些网络上大量重复的内容对用户来说是没有价值的,故就不会去收录,所以你要做的就是去提高内容的原创度。

9. 和网站主题相关度极低

打个比方,你运营的是一个专业卖衣服的网站,突然增加一个关于教人如何做金融投资的页面,主题差异相当大。这个时候,谷歌就很可能会因为相关度不高而拒绝收录。

对于这种情况,我的建议是直接删掉该页面。如果真的要做,至少要放到是在同一个行业性质的网站。

三、加快网站收录的方法?

如果你的网站页面不被谷歌收录,你可以尝试以下操作,帮助谷歌更好地收录你的网站页面:

1.在Google Search Console 中提交你的网站地图(sitemap):

通过提交网站地图,你可以帮助谷歌爬虫更快地发现你的网站页面。并且,在每一次发布文章之后,你都可以通过手动提交的方式来告诉谷歌你发布了新文章。

2.在网站内部建立有意义的链接:

通过在网站内部建立有意义的链接,你可以帮助谷歌爬虫更好地探索你的网站页面。有意义的意思是你要用有描述性的文本(不能是类似于click here)和确保你指向的链接内容是相关的。

3.使用正确的标签和元数据:

使用正确的标签和元数据(如 title 标签和 meta/description描述)可以帮助谷歌了解你的网站页面的内容,从而获得更好地排名。

4.确保网站内容有质量:

谷歌喜欢内容有质量的网站,如果四处抄袭、胡乱拼凑会受到谷歌的处罚。因此,确保你的网站内容有质量(特别是原创性)是非常重要的。

5.避免使用不当的 SEO 技术:

谷歌严厉打击使用不当的 SEO 技术,因此避免使用这些技术也是很重要的,

6.确保网站满足谷歌的质量标准:

谷歌有许多质量标准,如果你的网站不符合这些标准,可能会导致谷歌不愿意收录内容。质量标准有很多,我们上文中介绍的是谷歌比较看重的一些方面。

7.将你的网站链接提交到相关的网站和博客中:

获得高质量的外部链接可以帮助谷歌识别你的网站,并加速收录。

8.删除重复的或冗余的内容:

重复或冗余的内容可能会导致谷歌不愿意收录你的网站。

这些建议不一定适用于所有情况,但是可以帮助你更好地提高你的网站的可收录性。

搜索引擎收录一个网站需要时间,它要一个一个页面都爬过来,全都看过才行。如果半道上出问题了,比如网站自己设置了限制,或者网址错误网页打不开之类的,它的收录就少了。网站主要做的是把这些问题都解决掉,让搜索引擎顺顺利利把全站爬完,建好索引。

想了解更多:谷歌SEO、谷歌优化、外贸快车、小语种网站、谷歌ADS、Youtube视频、外贸牛、全球贸易通、扬州谷歌优化、杭州谷歌优化、上海谷歌优化、请添加

郑重声明:本文版权归原作者所有,转载文章仅为传播更多信息之目的,如作者信息标记有误,请第一时间联系我们修改或删除,多谢。